- 首页

-

超维产品

- 超维智能工业巡检平台

- 轮式巡检机器人

- 轨道巡检机器人

- 防爆巡检机器人

- 复合操作机器人

- 开关柜带电操作机器人

- AIoT联合巡检平台

- 解决方案

- 客户案例

- 新闻动态

- 服务支持

- 关于我们

全国服务热线:

400-155-6825

全国服务热线:

400-155-6825

引言

“深度学习”是我们在接触“巡检机器人”时经常遇到的一个技术名词,本文将由超维科技为大家阐释“深度学习”在巡检机器人中的应用。

1 概述

深度学习 ( Deep Learning,DL ) 是机器学习的一种,其算法基于对数据进行表征学习,能够发现大数据中的复杂结构,利用反向传播指导机器如何从前一层网络计算表征,从而改变每一层的内部参数。深度学习的目的是让机器人(Robotics) 具有与人一样的分析学习能力, 因其能够增强机器人的感知、决策与控制能力。具体到超维智能巡检机器人,主要涉及了目标检测、目标分类、特征匹配算法。综合利用上述算法模型,使超维智能巡检机器人能够准确感知服务器机柜上的报警指示灯和设备的状态信息,同时,根据不同模型的组合,也能将超维智能巡检机器人应用于配电房服务器,检测配电柜上的旋钮开关、压板开关、led、lcd等部件的位置和状态信息。下面分别对各个模型进行详细介绍。

2 目标检测模型

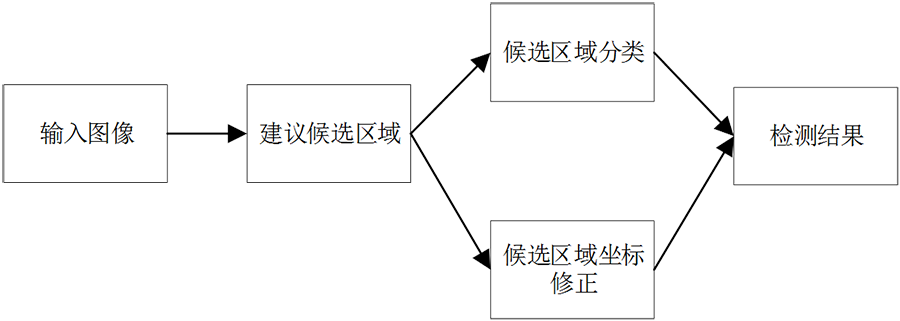

目标检测的基本任务是需要判别图片中被检测的目标类别, 同时需要使用矩形边界框来确立目标的所在位置及大小,并给出相应的置信度。作为计算机视觉领域的一个基本问题,目标检测也是许多计算机视觉任务如图像分割、目标追踪、图像描述的基础。目前主流的深度学习目标检测算法有两类,一类是基于区域建议的双阶段目标检测算法,如 R-CNN、SPP-Net、FastR-CNN、Faster R-CNN、FPN、Mask R-CNN等,另一类是基于回归分析的单阶段目标检测算法, 如YOLO系列、SSD系列、 RetinaNet等。2类的基本架构图下图所示:

(a) 双阶段目标检测算法

(b)单阶段目标检测算法

双阶段目标检测算法发展迅速, 检测精度也在不断提高, 但是自身体系结构的问题限制了检测速度.单阶段目标检测算法与双阶段目标检测算法最大的不同之处在于前者没有候选区域推荐阶段, 训练过程也相对简单, 可以在一个阶段直接确定目标类别并得到位置检测框。

考虑到现场部署的算力和检测速度,超维科技采用单阶段目标检测算法YOLO v5。YOLO系列从v1~v5,已经发展了5代,最新的版本为YOLOv5 6.0版本。YOLO v5可以说是目标检测目前各种增强数据的集大成者,包括在输入端采用Mosaic数据增强、自适应锚框计算,自适应图片缩放,在主干网络,采用focus结构和CSP结构,在Neck部分,采用FPN+PAN的结构,在训练时,采用GIOU_Loss等。

超维科技在YOLOv5的基础上,为了适应服务器机房指示灯的小目标模型,采用了以下技术,对模型进行了改进,有效提高了目标的检测精度。

(1)修改模型的neck, 将当前的PAN-Net替换为bi-FPN,以提取图像的细节信息。

(2)采用分图的方法进行检测。检测时,将一张图分为9张图,每2张图的重叠区域为10个像素,这样做是防止一个目标被分为二个目标检测。9张图做完检测后,进行非极大值抑制,去除重叠的检测框,得到一张图的检测结果。

(3)采用2张照片将进行检测,一张为长曝光,一个为短曝光。将2张照片按照方法(2)进行检测,最后再做一次非极大值抑制,得到最终的灯检测结果。

(4)采用α-IOU技术,对原来的YOLO v5的IOU 损失函数进行改进,增强小目标的损失权重,降低因区域重叠而漏检的概率。

(5)将主干网络的第四层输出的特征图与金字塔特征提取网络的特征图相结合,输出为P2检测头,这样就提高了模型对图像检测的分辨率,增强了模型对细微特征纹理的提取,减少了小目标的漏检。

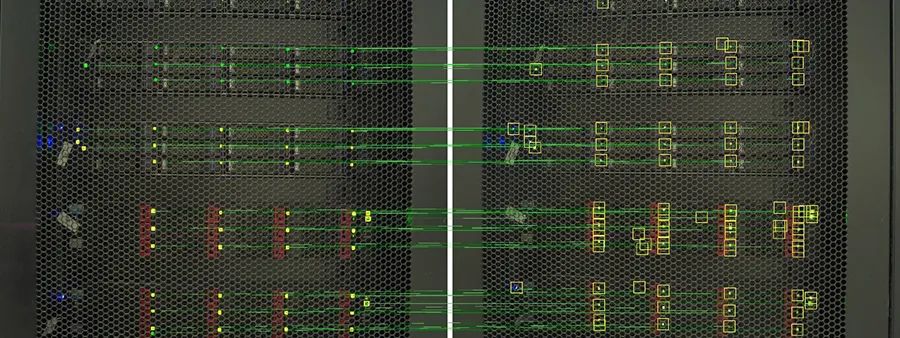

小指示灯的检测结果

经过对YOLO v5的改进,针对指示灯小目标的检测精度在97%以上。

3 目标分类模型

图像分类任务是计算机视觉中的核心任务,其目标是根据图像信息中所反映的不同特征,把不同类别的图像区分开来。从已知的类别标签集合中为给定的输入图片选定一个类别标签。图像分类模型在巡检任务中主要应用于目标的状态分类。在经过目标检测模型后,检测到的目标截图输入目标分类模型,实现目标状态的分类。例如识别指示灯的颜色,开关的状态,旋钮开关的挡位等。经典的基于深度学习的图像分类方法有AlexNet,VGG,GoogLeNet,ResNet等,这些模型的模型深度较少,泛化能力较弱。

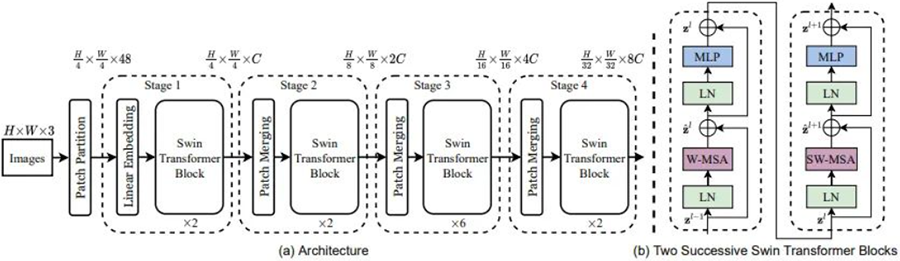

针对现场视角、光照、尺度、遮挡、形变、背景杂波、类内形变、运动模糊、类别繁多等问题,超维科技采用CSWinTransformer模型实现图像的分类。CSWin Transformer是2021年提出的基于Transformer的图像分类模型。相比于传统的卷积神经网络,Transformer 学到的更多的是特征彼此之间的相互关系,普适性更好,不完全依赖于数据本身;Transformer关注的不仅仅是局部信息,有一个从局部到全局这样的一个扩散的机制去寻找更合适的特征表达。

而CSWinTransformer采用十字形状的自注意力机制,能够在水平和垂直两个方向上同时计算注意力权重。除此之外,CSWin Transformer还采用一种局部增强的位置编码,相比于以前的位置编码,位置编码有两个好处:

(1)能够适应不同大小的输入特征;

(2)具有更强的局部假设偏置。采用CSWin Transformer的另一个原因是相对于其他的基于Transformer的图像分类模型,由于采用十字形状的自注意力机制,模型的参数量和计算量较小。模型的架构如下所示:

采用该目标分类模型,在不同的光照和角度下,颜色误分率在1%以内,能满足现场巡检的需求。

4 特征匹配

特征匹配是指将两幅图像具有相同或者相似属性的内容或结构进行像素上的识别与对齐。一般而言,待匹配的图像通常取自相同或相似的场景或目标,或者具有相同形状或语义信息的其他类型的图像对,从而具有一定的可匹配性。特征匹配在巡检任务中,主要功能是通过巡检照和基准照的匹配,确定每个小指示灯的ID,明确每个小指示灯的功能。当服务器指示灯产生报警信号时,通过每个指示灯的ID,能够快速获得报警信息。

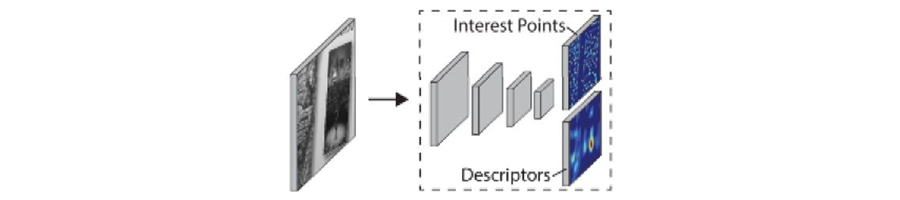

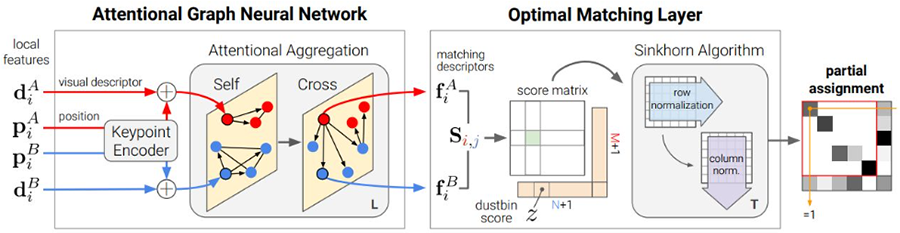

经典的特征匹配算法是SIFT 算法和 ORB,但SIFT 算法是对图像进行全局的特征点检测耗时较长,造成算法的运行速度慢,达不到令人满意的匹配效果。ORB 算法的运行速度较快,但是因为其描述子不具有尺度不变性,所以匹配效果不理想。因此我们采用 SuperPoint 提取图像特征,采用2020年提出的 SuperGlue 特征匹配算法匹配服务器小指示灯。

模型的整体架构如下图所示:

(a) SuperPoint提取图像的特征点

(b) SuperPoint 根据特征点进行匹配

(c) 匹配效果图(左边是基准照,右边巡检照)

基于SuperPoint和SuperGlue的匹配算法在现场测试中,匹配准确率在98%以上。